从零开始实现高速 LLM 推理

andrewkchan.dev/posts/yalm.html

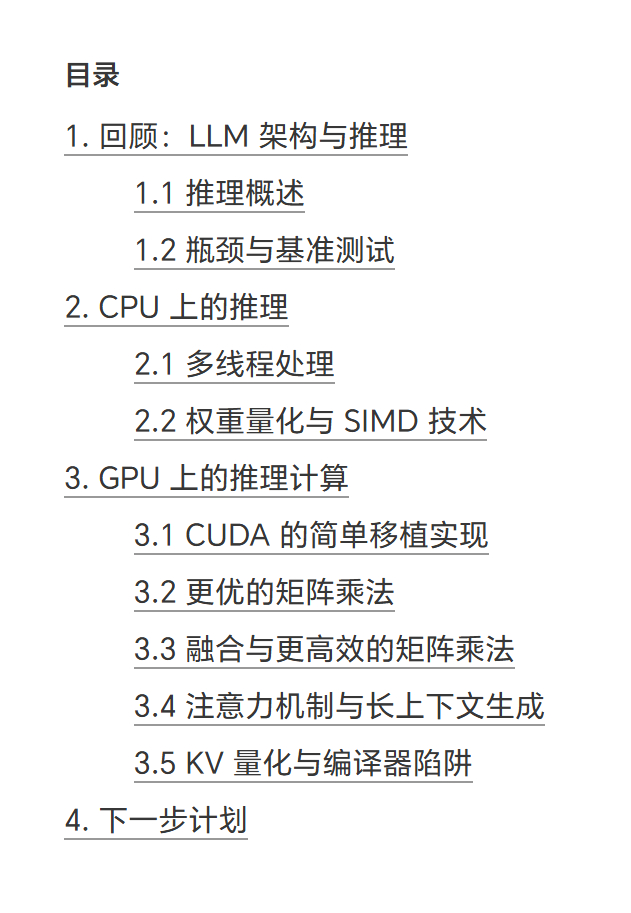

"这篇文章讲述如何从零开始,仅用 C++和 CUDA 而不依赖任何库来构建一个 LLM 推理引擎。

为何如此?通过这种方式,我们可以了解 LLM 推理的全栈技术——从 CUDA 内核到模型架构,这正变得日益重要 1,并真切感受不同优化对推理速度的影响。其中最重要的应用场景之一便是在消费级设备上实现单条提示词的快速运行 。

这正是我们要聚焦的方向:构建一个能够加载常见开源模型权重的程序,在单 CPU+GPU 服务器上实现单批次推理,并通过迭代优化使令牌吞吐量最终超越 llama.cpp。读者需具备大型语言模型、注意力机制及 Transformer 的基础知识。完整源代码已发布于 GitHub"

AI创造营