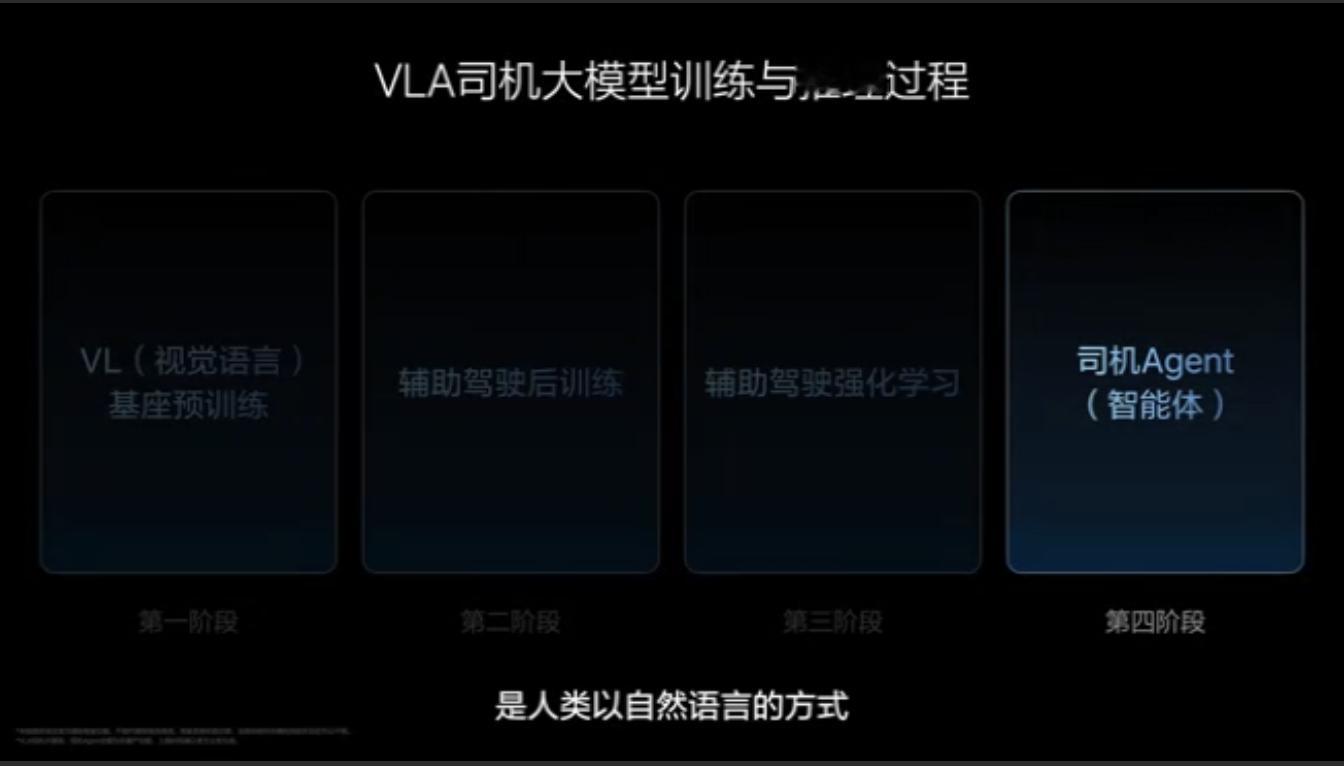

李想:“VLA司机大模型训练VLA即VL(视觉语言)+A(行动),其训练分三阶段类比人类学开车”.

1️⃣预训练筑牢视觉语言基座VL,数据包含10倍高清2D图像与3D物理世界视觉、交通驾驶相关语言、导航地图与驾驶决策等VL联合语料,云端320亿参数基座模型蒸馏为32亿参数端侧模型(8专家MoE结构)适配车端芯片;

2️⃣其次后训练通过模仿学习接入驾驶动作数据形成VL到VLA的端到端链路,模型扩至40亿参数,限制2-3步思维链并叠加扩散模型预测4-8秒轨迹;

3️⃣最后强化训练分RLHF(基于人类反馈校准安全合规与驾驶习惯)和纯RL(以舒适性、零碰撞、守交规为目标在世界模型中自我超越)。

最终构建的司机智能体支持自然语言交互,短指令端侧处理、复杂指令云端解析后执行,实现类人类司机的沟通决策能力,全程无先例可循,在视觉语言与驾驶行动闭环、类人交互等方面突破创新。理想AI Talk第二季李想谈辅助驾驶到了新十字路口