刚刚,DeepSeek开源了全新的OCR模型——

相较于去年10月20日发布的初代模型,DeepSeek-OCR2的核心突破在于打破了传统模型死板的“光栅扫描”逻辑,实现了根据图像语义动态重排视觉标记(VisualTokens)

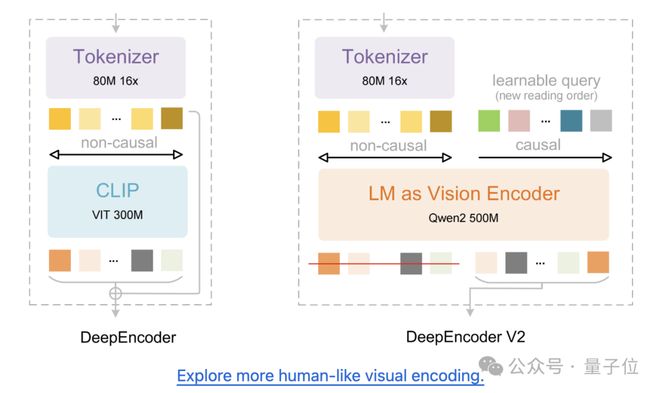

为此,DeepSeek-OCR2弃用了前作中的CLIP组件,转而使用轻量化的语言模型(Qwen2-0.5B)构建DeepEncoderV2,在视觉编码阶段就引入了“因果推理”能力。

这一调整模拟了人类阅读文档时的因果视觉流,使LLM在进行内容解读之前,智能地重排视觉标记。

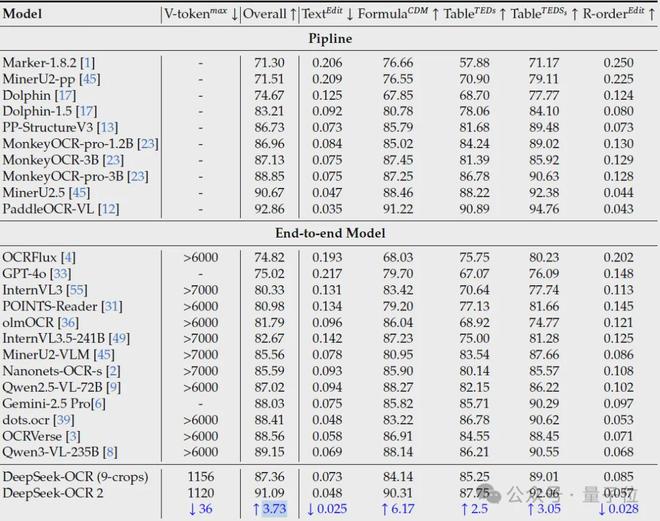

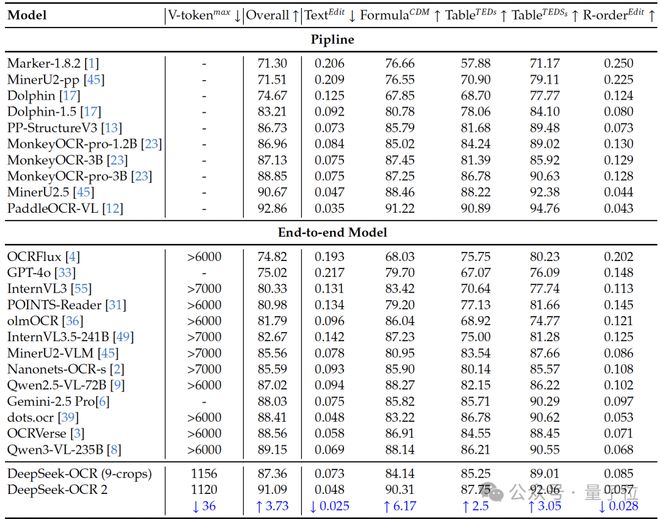

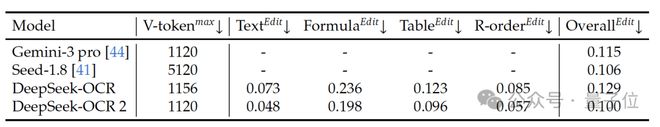

性能上,DeepSeek-OCR2在仅采用轻量模型的前提下,达到了媲美Gemini-3Pro的效果。

在OmniDocBenchv1.5基准上,DeepSeek-OCR2提升了3.73%,并在视觉阅读逻辑方面取得了显著进展。

值得一提的是,这次最新论文的作者依然是:魏浩然,孙耀峰和李宇琨三人组。

接下来,我们一起来看。

核心更新:DeepEncoderV2

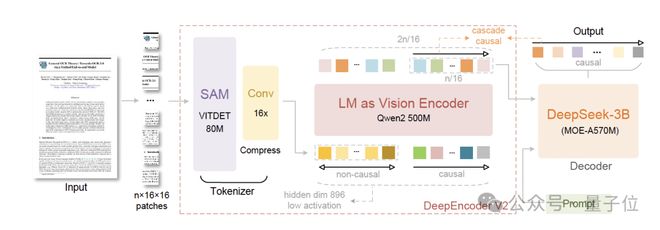

DeepSeek-OCR2延续了前代OCR模型的经典架构,由编码器和解码器协同工作。

编码器负责将图像离散化为视觉标记(VisualTokens),解码器则结合这些标记与用户指令生成最终文本输出。

如论文所说,DeepSeek-OCR2此次核心的升级在于编码器——

DeepEncoderV2

传统的视觉编码器通常按照固定的“光栅扫描”(从左到右、从上到下)顺序处理图像,这在面对复杂版面(如双栏文档、错落的表格)时,往往会切断语义的逻辑连贯性。

而DeepEncoderV2这次的更新解决的正是这一问题。

将此前的CLIP组件替换为轻量化的LLM架构(Qwen2-0.5B),这一转变赋予了编码器因果推理能力

信息进入主解码器之前,编码器就先对视觉标记进行“智能重排”,使其更符合人类阅读逻辑。

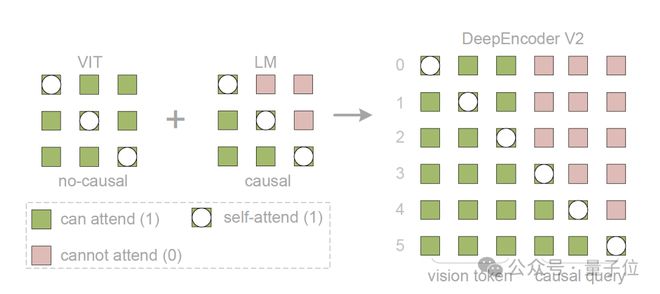

为了实现这种智能重排,DeepEncoderV2引入了一种全新的双流注意力机制,其底层逻辑通过一个定制的注意力掩码(AttentionMask)来约束:

这种设计使得视觉标记之间互不干扰(保持原始特征),但每一个查询标记却被强制要求只能“看到”它之前的标记以及所有的视觉标记。

相比传统的交叉注意力结构,这确保视觉信息在所有层中都保持“活跃”,从而与因果查询进行深度信息交换。

此外,这实际上还建立了两阶段级联推理,成功弥合了2D空间结构与1D语言建模之间的鸿沟:

换句话说,在V1中,图像进入LLM时,顺序是写死的。

而在V2中,通过查询标记(LearnableQuery)的重排,模型在进入主解码器之前,就已经在编码器内部完成了一次“逻辑理顺”

其他组件

介绍完DeepEncoderV2的核心升级后,我们来串一下DeepSeek-OCR2的整体架构:

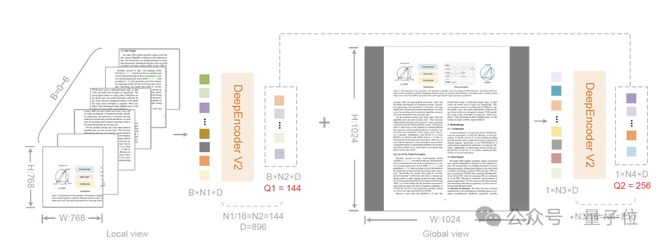

首先是一开头的视觉分词器(SAM),其沿用了此前的架构,采用了80M参数的SAM-base架构,并结合两层卷积层。

输出维度从前代的1024优化缩减至896,以对齐后续管线,这套分词器的设置实现了16倍的标记压缩

这种基于压缩的设计,以极小的参数开销,极大地释放了后续全局注意力模块的计算压力,让模型运行更轻快。

此外,为了在处理不同分辨率图像时“不丢细节”,DeepSeek-OCR2在编码阶段还引入了灵活的裁剪方案:

最终输入LLM的标记总数稳定在256到1120之间,与Gemini-1.5Pro的视觉预算相匹配。

最后,在后端解码器部分,DeepSeek-OCR2保留了3B参数的MoE结构(实际激活参数仅约500M)。

训练流程与实验验证

在数据策略上,DeepSeek-OCR2延续了与前代相同的数据源,OCR相关数据占比达80%。

其关键优化点有二:一是采样均衡化,将正文、公式与表格按3:1:1比例划分;

二是标签精简化,合并了如“图片说明”与“标题”等语义相似的布局标签。这种极小的底层差异,确保了其与基准测试之间具备高度的一致性与可比性。

在训练流程方面,DeepSeek-OCR2采用了三阶段的训练Pipelines:

在实验阶段,DeepSeek-OCR2主要在OmniDocBenchv1.5上进行评估,包含1355个页面,涵盖杂志、学术论文、研究报告等9大类文档。

并与Gemini-3Pro、Qwen2.5-VL、InternVL3.5等先进模型及多种专业OCR方案进行对比。

如开头所示,DeepSeek-OCR2在OmniDocBenchv1.5上达到了91.09%的性能,相比基线提升了3.73%

阅读顺序(R-order)的编辑距离从0.085显著降至0.057,证明了DeepEncoderV2重新编排视觉信息的能力。

在相似的标记预算(1120)下,DeepSeek-OCR2的文档解析编辑距离(0.100)优于Gemini-3Pro(0.115)。

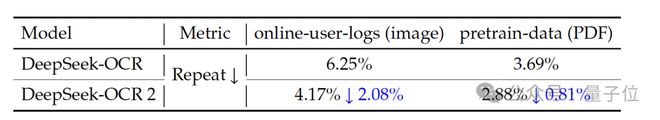

在实际生产中,在线用户日志的重复率从6.25%降至4.17%,PDF生产数据重复率从3.69%降至2.88%,证明了模型逻辑视觉理解能力的提升。

整体来看,DeepSeek-OCR2在保持高压缩率的同时实现了显著的性能提升验证了使用语言模型架构作为视觉编码器的可行性,这为迈向统一的全模态编码器(omni-modalencoder)提供了路径。

Onemorething

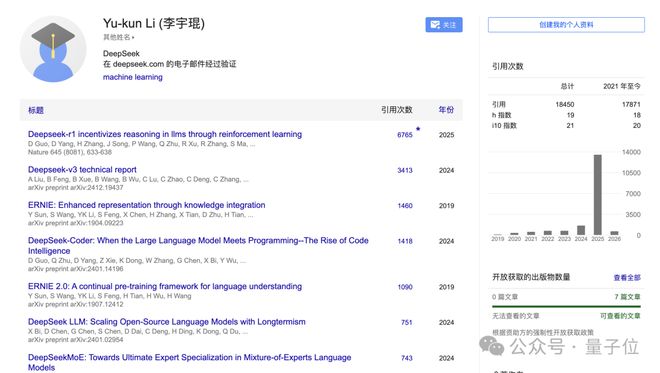

这篇论文的三位作者分别是:魏浩然,孙耀峰和李宇琨。

魏浩然曾就职于阶跃星辰,当时主导开发了意在实现“第二代OCR”的GOT-OCR2.0系统。

孙耀峰本科就读于北京大学,现于幻方AI从事大语言模型的相关研究,R1、V3中都有他的身影。

李宇琨,谷歌学术论文近万引研究员,也持续参与了包括DeepSeekV2/V3在内的多款模型研发。

最后,OCR2延续了DeepSeek团队一贯的开源精神。

项目已在GitHub开源,并同步上线HuggingFace,论文也一并释出。

GitHub:https://github.com/deepseek-ai/DeepSeek-OCR-2

HuggingFace:https://huggingface.co/deepseek-ai/DeepSeek-OCR-2