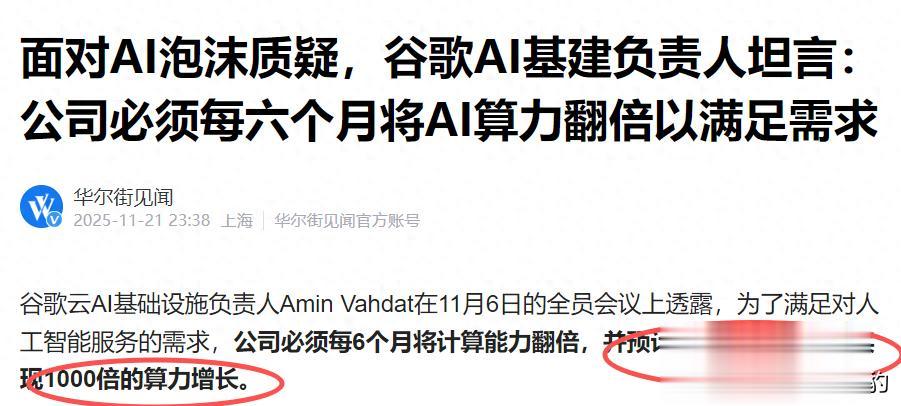

“我们必须每6个月将算力容量翻倍——未来4到5年,目标是实现1000倍能力提升。”就在周末,谷歌云AI基础设施负责人Amin Vahdat在内部会议上抛出一句看似冷静却分量足的话。

根据谷歌目前AI的发展情况来看,这可能这不是口号,而是一份计划。当然该目标为谷歌内部技术路线展望,实际落地受限于工艺、能耗、应用场景等多重因素。

在过去两年,AI行业的聚光灯始终聚焦于“GPT vs Gemini”、“千亿参数 vs 多模态能力”这类表层对决。

但谷歌正在悄悄构建一个更底层、更庞大的系统工程,它不再只是比谁的模型更大,而是在比谁的“AI工厂”更高效、更可持续、更能触达真实用户。

一、大模型只是冰山一角很多人以为AI竞赛的核心是算法和模型,但在谷歌看来,“水下”算力、存储、网络、能效,以及它们之间的极致协同。

以谷歌最新一代自研芯片TPU“Ironwood”为例,其在内部测试中已实现:

每瓦特推理性能提升6倍,训练效率提升3.8倍

这不仅是芯片的进步,更可能是整套基础设施的跃迁。

配合其自研的光互联架构“Helix”,AI集群间的通信延迟被压缩至微秒级,让万卡规模的集群扩展效率逼近理论极限——几乎线性增长。

更关键的是,谷歌正全面转向“AI原生数据中心”设计:

从冷却系统到供电架构,从布线布局到机柜结构,全部围绕TPU进行深度优化。

结果?整体PUE(能源使用效率)低至1.08,远优于行业平均的1.55。

这意味着,在同样的电力投入下,谷歌可能能跑出近50%更多有效算力。

二、AI的用户在哪里再强的模型,若没有真实用户交互,终归是空中楼阁。

而谷歌的优势恰恰在于。它拥有一个每天触达数十亿人的超级生态。

截至2025年第三季度(Statista数据),Gemini应用的月活跃用户已达6.5亿,较年初暴增210%。这个数字或许不如OpenAI宣称的“8亿周活”耀眼,但需注意两点关键差异:

周活 ≠ 月活:8亿周活若换算为月活,实际可能低于6亿;

集成深度不同:ChatGPT主要依赖独立App或网页端,而Gemini已深度嵌入谷歌的“操作系统+搜索+视频+广告”全链路。

具体来看:

Android 16(覆盖全球32亿设备)原生集成Gemini;

Gmail智能回复、YouTube内容理解、Google Search实时推理等场景全面启用;

用户日均交互频次高达4.7次,远超ChatGPT的1.2次(SimilarWeb数据)。

相比ChatGPT更依赖独立入口,Gemini的策略是通过系统级集成提升用户粘性,两者路径不同,各有优劣。

当AI成为用户日常行为的一部分,粘性与商业价值自然水涨船高。

三、谷歌的算力市场普遍认为,AI算力扩张 = 采购英伟达GPU + 组装服务器。

但谷歌已走上另一条路:垂直整合 + 极致定制。

它不再采购标准AI服务器,而是将详细设计图纸直接发给少数几家ODM厂商,要求“照图制造”,甚至对公差控制到0.1毫米以内。

从芯片(TPU)、整机、机柜到数据中心,全部自研或深度定制。

这种模式虽然前期投入巨大,但长期看,它带来了三大优势:

成本可控:摆脱对通用硬件的依赖;

性能极致:软硬协同优化,效率最大化;

供应链安全:减少地缘政治风险。

这也意味着,谷歌的算力扩张并非简单堆量,而是一场精密的“工业级重构”。

对于我们而言,与其紧盯模型参数,或许不如关注其背后产业链上的核心供应商。

写在最后Gemini 3或许不是当前参数最大、benchmark分数最高的模型,但它背后站着一个现金流健康、用户基数庞大、算力持续指数增长的科技巨头。

谷歌的AI战略,从来不是一场短跑冲刺,而是一场马拉松式的系统工程。

它不靠单一技术突破取胜,而是通过芯片+基础设施+操作系统+应用场景的四重闭环,构建难以复制的护城河。

在AI投资的下半场,机会或许不在“谁发布了新模型”,而在“谁真正把AI变成了水电煤一样的基础设施”。

特别声明:以上内容绝不构成任何投资建议、引导或承诺,仅供学术研讨。

如果觉得资料有用,希望各位能够多多支持,您一次点赞、一次转发、随手分享,都是笔者坚持的动力~

评论列表