作者 |德新

编辑 |王博

本月,CES 2026在拉斯维加斯落幕。 如果要用一句话概括今年的主题,那就是——AI Everywhere,而且不再是概念层面的,而是正在以算力、模型以及各式各样的硬件载体,真实地进入物理世界。

在展会开幕前一天,英伟达黄仁勋与AMD苏姿丰隔空对垒;次日,两人又罕见同台一起出现在了联想的舞台。在全球最大的球形LED场馆Sphere,联想将英伟达、高通、AMD、Intel 等一众AI核心玩家聚集在同一场发布会中,把「未来将至」的氛围推向了高潮。

无论是老黄祭出的单板推理算力提升5倍的Vera Rubin,还是苏姿丰携手李飞飞展示World Labs 如何赋予模型空间理解能力,都在传递一个清晰而一致的信号:由更大算力、更强模型驱动的AI,正在从数字世界向物理世界全面地渗透。

而CES恰恰也是汽车科技最重要的秀场之一,汽车作为当下应用规模最大、商业价值最高的“物理AI终端”,正处于这场技术海啸的最前沿。

一、FSD V14.2 + Grok:大模型上车进入实战阶段事实上,在CES之前,大模型上车已展现出明确的进化曲线。

从去年10月起,特斯拉向部分HW4.0硬件车主推送了FSD V14。如果说FSD V13印证了端到端模型的可行性,那么V14则是Scaling Law在车端「暴力美学」的初次展现。马斯克曾在X上透露,V14的参数规模相比V13提升了一个数量级(10倍)。

图片来源:notateslaapp.com

在年末的假日更新中,特斯拉进一步将Grok引入智能座舱,并与车机导航和交互系统深度融合。HiEV在Model Y上对Grok进行了实地体验,可以明显感受到:在端云结合的架构下,Grok已经具备了相当完善的大模型能力,不只是“语音助手”的增强版,而是一个非常接近于专家级真人、具备强逻辑推理能力的“助理”。

FSD V14.2与Grok的组合,用真实的体验验证了:在车端,更大的模型规模是通往更强智能的可行路径。而这背后,是HW4.0约500 TOPS级别的算力,以及预埋的AMD Ryzen座舱芯片共同构成的计算基础。

车端的Scaling Law,从未比此刻更加清晰。

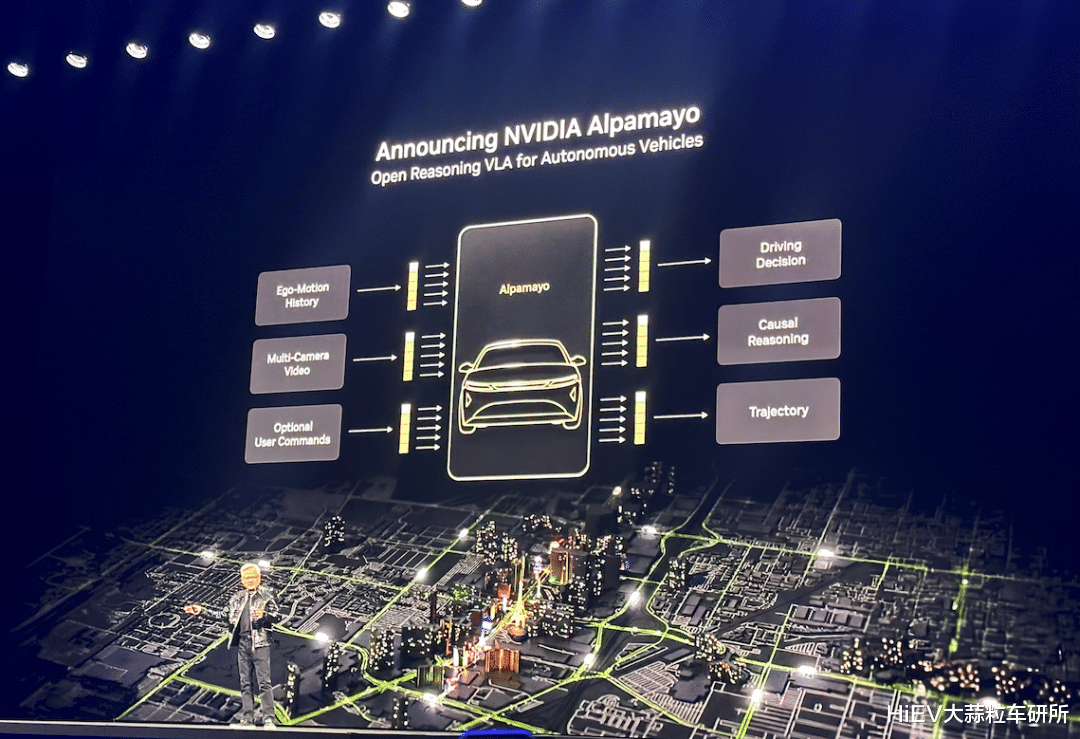

二、从特斯拉到英伟达:模型、算力正在同步放大在CES的主题演讲中,黄仁勋还宣布开源自动驾驶VLA模型Alpamayo,这是一个约10B参数规模的模型。

图片来源:HiEV拍摄

老黄提到,在过去一年里,英伟达已经成为全球开源模型数量最多的AI公司。英伟达希望通过以开源Alpamayo这样的方式,加速自动驾驶的探索,推动极致L2+乃至L4更早落地。如果说英伟达和AMD是AI时代最重要的“军火商”,那么联想的角色,则更接近于将这些能力转化为可落地产品的集成者。

在CES 2026上,联想以「Smarter AI for All」为主题,展示其“让AI成为普惠能力”的战略定位。也是这一定位,使它能够将英伟达、高通、AMD、Intel等多家顶级芯片公司的掌门人,拉到同一个舞台。

在汽车领域,这一逻辑也是类似。联想于2022年成立联想车计算,加速AI能力向车端迁移;到去年,其车计算业务已经在多家车企与Robotaxi企业的新车型上量产。

三、汽车的算力需求,正在逼近PC行业今天英伟达Thor的AI推理性能,已经大致相当于一张中高端PC显卡。

而联想车计算早期曾经做过一个大胆的测算:到2030年,汽车行业对算力的总体需求规模,将与PC行业相当。

中国市场,几乎是这轮车端算力爆发的策源地——从AGX Drive Xavier,到Orin X,再到Thor U,中国车企几乎无一例外,都是全球首发或首批落地。

图片来源:联想车计算

联想车计算也是赌定这一趋势,大约在2023年3月,其已经与英伟达签约取得了最早一批Thor的授权,并开始开发车载计算平台。

L4自动驾驶域控制器AD1,图片来源:联想车计算

到了2025年,其基于Thor的产品也陆续落地:针对L4级自动驾驶市场推出的域控制器AD1,它基于两颗NVIDIA DRIVE AGX Thor,拥有超过2000 TOPS算力的L4自动驾驶域控,已经上车文远知行、Nuro等头部自动驾驶公司的Robotaxi;

AH1则是L2++级的辅助驾驶域控制器,其采用一颗NVIDIA DRIVE AGX Thor,在新一代智己LS6以及LS9上量产,市场表现亮眼。

此外,基于联想在移动设备领域的长期积累,其为智能汽车打造的多端互联方案,也已上车奇瑞星纪元ET、ES,并于广州车展与奇瑞iCAR V27上联合展示。

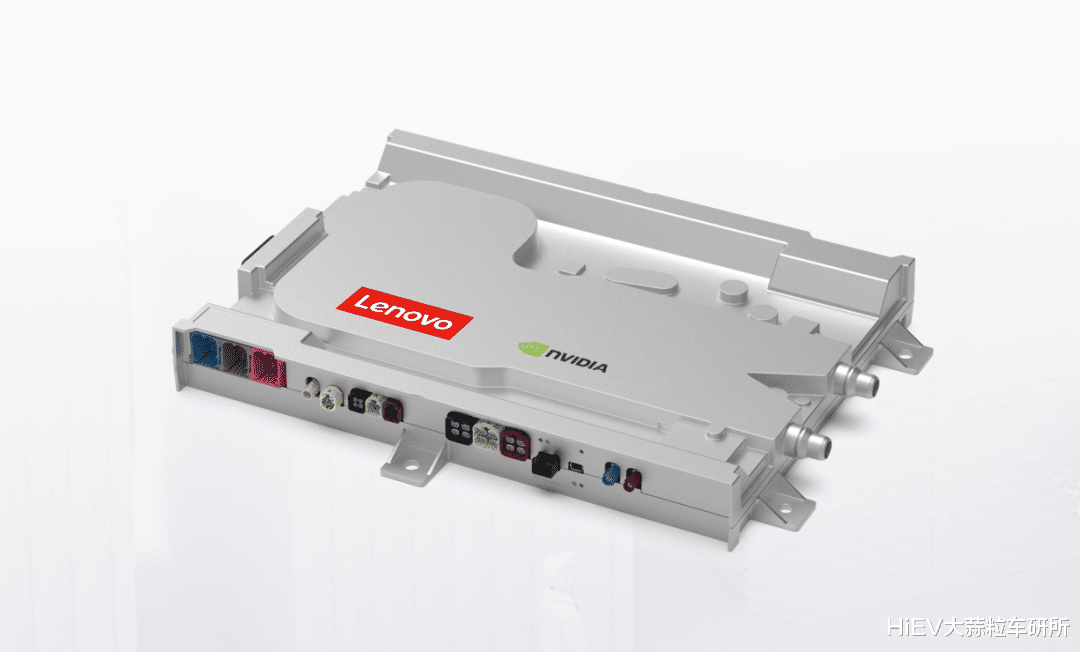

在本届CES上,联想车计算还发布了全新的Auto AI Box产品。该产品的定位是在座舱大模型加速上车的时期座舱芯片算力的重要补充。

图片来源:联想车计算

比如汽车厂商采用典型的高通骁龙8155或8295座舱芯片,可以外接英伟达Thor的算力,用于支持大模型上车的现实需求。这一方案的价值在于:

无需改变原有座舱域控制器架构,即可显著提升AI算力;

相比行业典型的下一代旗舰级座舱芯片,成本更可控;

产品成熟度高,上车验证周期更短。

从Sphere场馆内老黄与苏妈同台,到特斯拉FSD V14+Grok的组合体验,2026年的智能车行业滚滚向前的路径已经非常明确:汽车正在成为算力密度以及模型推理复杂性最高的移动终端。

在“大模型狂热”之后,行业开始进入拼落地、拼体验、拼效率的下半场。通过Thor系列的高端占位与Auto AI Box的灵活降维,联想车计算正试图在汽车这个「新超算」上,成为主机厂可靠的算力合伙人,共同解锁自动驾驶出行新的可能性。