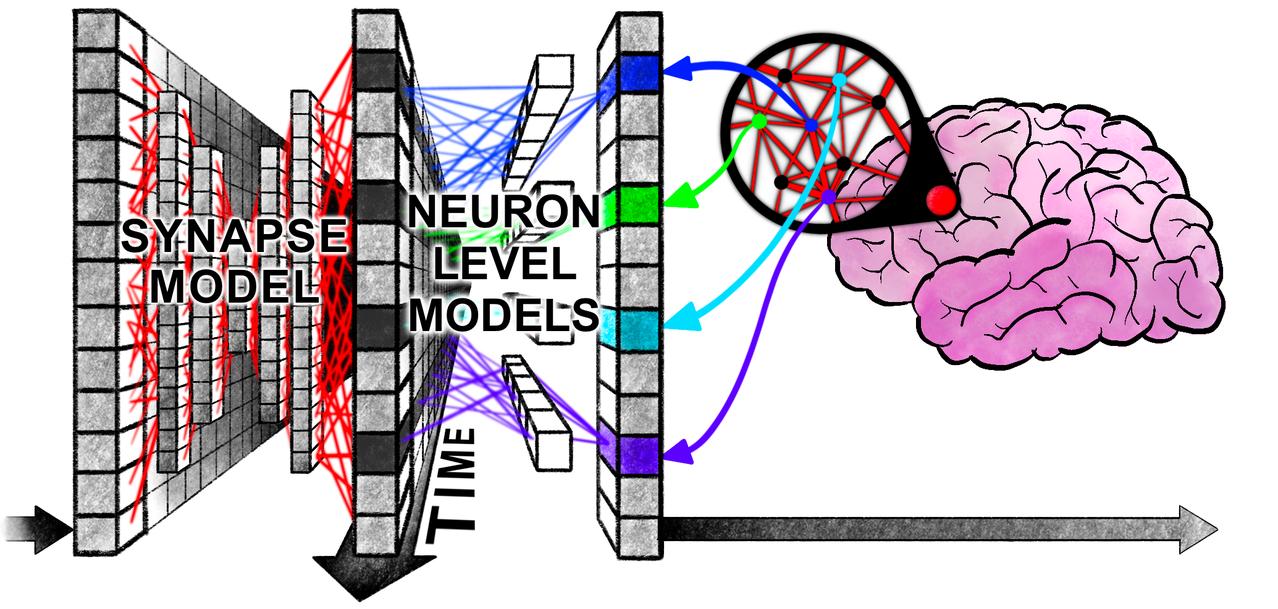

Transformer作者Llion Jones创办的Sakana AI公司,提出了新框架CTM,主打让AI像人类大脑一样“思考”。 CTM受两个大脑机制启发: 1. 神经元级时序处理(Neuron-level Temporal Processing):这是种“带记忆的神经元”,它让整个模型具备了复杂的时间动态,类似生物神经元中的突触可塑性和时间依赖激活。 在普通神经网络中,每个神经元只计算当前输入,激活后就完事。但CTM里,每个神经元都有自己独立的小模型(MLP),可以记住并处理一段时间内的输入历史。 2. 神经同步(Neural Synchronization):相当于“AI的脑电波”,直接用作模型的中间表示,用来观察数据、进行推理和给出输出。 有了它,CTM不只关注每个神经元的输出值,而是看它们在时间上的协同关系,也就是哪些神经元一起活跃、一起沉默。 这两个机制共同支撑起了一个新的维度:内部时间(Internal Ticks),也可以理解为模型“内部思考的步数”。 不像传统模型那样一步步处理外部输入,CTM每一步都在进行一次全模型内部的同步演化,也就是说,即使输入的是张静态图片,CTM也能在“脑中反复思考”几十次,再决定输出什么。 从实验结果看,这种架构不仅有趣,还确实有效: - 在ImageNet图像分类任务上,CTM展现出更可解释的注意力模式,预测过程像“在环顾四周思考”,并能动态决定“思考多少步”再输出; - 在“2D迷宫求解”任务中,CTM可以不依赖位置编码,而是边走边“构图”,成功走出更大更复杂的迷宫,这说明它真的在进行某种内部空间规划; - 在序列推理(比如Parity任务) 上,CTM展示出明确的“规划式注意力”,有些模型会先扫一遍全局再统一输出,有些则会逐步计算,策略高度可解释; - 在”问答版MNIST任务“中,CTM靠神经元的同步模式,能记住很久以前的输入,而不是传统的短期激活记忆; - 在强化学习(如MiniGrid) 场景下,CTM也表现出可持续使用历史激活参与决策的能力,表明它在动态环境中,依旧能“连贯思考”。 综上,CTM的设计让“思考”成为了AI的内建结构,它不是被迫一次输出,而是可以在内部自己选择“想几步”。 这背后的原理也很好理解:时间本身,就是智能的一部分。 人脑处理信息,不是快就是好,而是通过在时间中展开推理、整合、调整。 而CTM正是引入这一“时间维度”来激活更复杂的智能行为。 目前,CTM并非以性能为主打,它的重点在于探索一种更接近人脑的计算方式。 Sakana也明确表示,他们关注的是模型行为是否合理、有解释性、有泛化潜力,而不是打破某个排行榜。 未来是否能靠这类模型让AI变得更像人,让我们拭目以待。 感兴趣的小伙伴可以点击: 论文: 源码:-thought-machines/