理论上,大算力 + 大数据 + 云端大模型 是阶段性辅助驾驶迈向下一个台阶的关键。

但这里面,确实不出现了不同的分歧:

一个是『大算力 + 大数据 + 云端大模型 』 搭配 纯视觉;另一个是『大算力 + 大数据 + 云端大模型 』 搭配 多传感器融合。

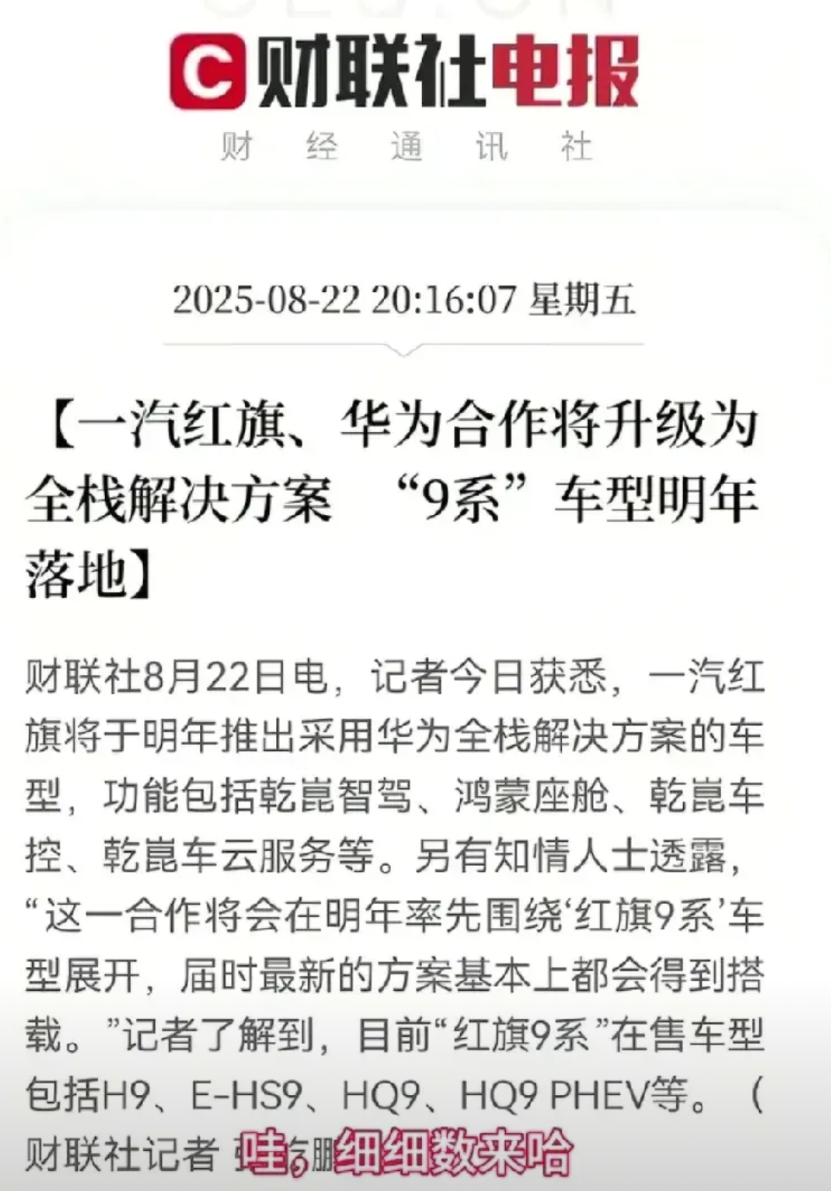

但目前的实际情况是 『中算力 + 大数据 + 暂定是否云端模型』 搭配 多传感器,这个方案目前除了华为是周知的原因,那其他家其实也是延续着这个逻辑在走。

华为 比较特殊的原因在于,其实没人比华为更懂技术了,它的选择分为被动和主动,它现在的局面其实是被动选择,但它不讲道的地方在于,它主动的选择从 体验 倒推技术选择。

结果也很简单:这是体验派的第一名。

但我们能看到的是,现在其他的多传感器企业,它所用的雷达精度没那么高。

精度没那么高的雷达,对于 小、远、体态奇怪 的障碍物识别其实很差。

并且雷达没有语意信息,能够挖掘的潜力其实不够。

我们还是要看,纯视觉究竟能解决什么?

我们平时听了这么多公司的技术故事,务实或者说很功利地问,这些都有啥用?

宏观说解决『信息带宽』问题。

之前在特斯拉上OCC 写的内容里讲过,还是视频流里面蕴藏的信息量理论上靠模型 + 算力就可以挖掘出「存在性(lidar很擅长)」之外的信息,包括意图和未来的画面(预测推理)。

微观讲,有若干感知、预测、推理任务可以通过视觉信息来做,解决自动驾驶长链条上的一些垂类问题(可以举很多案例,比如各类道路参与者意图)。

举个例子,过马路的行人,视觉视频流里可以直接反映,人 脸的朝向,光这一点信息去判断人的行经轨迹是比较简单的。

但雷达则不然。

激光雷达工程师普遍还是认为是安全冗余,对物体存在性的一种保障。

视觉更有吸引力(挖掘视频量信息更有技术挑战,相关技术更符合大模型这种技术演进趋势)。

我们清楚了,视觉的潜力大,但对算力、数据、算法要求极高,极高。

但如果 同样是 大算力 + 大数据+ 大模型,但是多传感器呢?