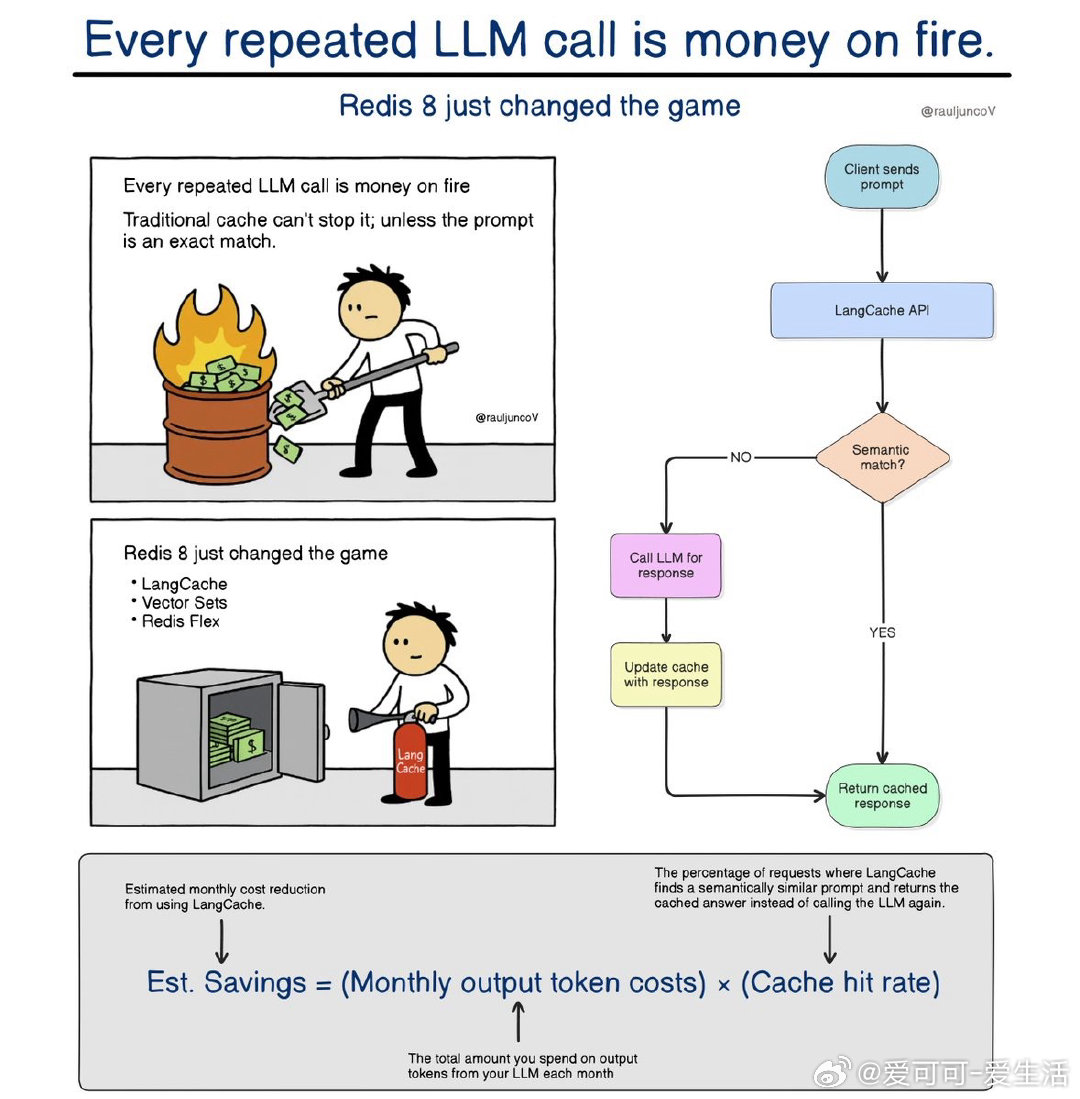

每次重复调用 LLM 都是在烧钱,传统缓存只能精确匹配,无法解决语义多样性问题。Redis 8 打破局限,带来语义缓存革命:

• LangCache:基于语义向量匹配缓存,不再依赖完全相同的字符串输入。通过嵌入向量找出语义相近的历史请求,命中则直接返回缓存结果,节省大量计算成本和响应时间。

• Vector Sets:Redis 原生支持向量相似度搜索,无需外接向量数据库。快速检索语义相近的条目,提升推荐、搜索、实体解析等场景效果。

• Redis Flex:混合 RAM+SSD 存储,扩大缓存容量,降低成本。热点数据保留在内存,冷数据转移至 SSD,实现高效且经济的缓存扩展。

核心价值:传统缓存基于键匹配,面对表达差异极大的自然语言请求失效,导致频繁调用 LLM 浪费资源。Redis 8 通过理解“意义”而非“字面”,大幅提升缓存命中率,降低重复计算,实现更快更省钱的智能缓存。

示意流程:

用户请求 → LangCache 查询语义相似缓存 → 命中返回缓存结果,未命中调用 LLM → 缓存更新响应

节省公式:

预估节省 = (每月输出 token 费用)×(缓存命中率)

对 LLM 应用、聊天机器人、RAG、智能代理等场景意义巨大,迈向更智慧、更经济的 AI 基础设施。

详细解析👉 newsletter.systemdesignclassroom.com/p/every-repeated-llm-call-is-money-on-fire

示例图与流程👉 twitter.com/RaulJuncoV/status/1954876732261253578

语义缓存 Redis8 LangCache 向量搜索 智能缓存 LLM成本优化