麒麟9030逆袭:手机跑30B大模型,竟比万元电脑还快?

你还在为运行强大AI模型需要昂贵电脑而发愁吗?科技的浪潮奔涌向前,这一次,答案可能就握在你的掌心!华为最新旗舰芯麒麟9030以其惊艳的本地AI推理能力,正悄然改变游戏规则。尤其当面对庞大的30B级别大语言模型时,它的表现竟能让一些传统高性能电脑处理器也黯然失色——比如苹果的A19 Pro。这不是科幻,而是正在发生的现实。让我们用数据和事实说话,揭开麒麟9030本地AI推理的神秘面纱。

手机芯PK电脑U:30B模型推理效率实测惊人

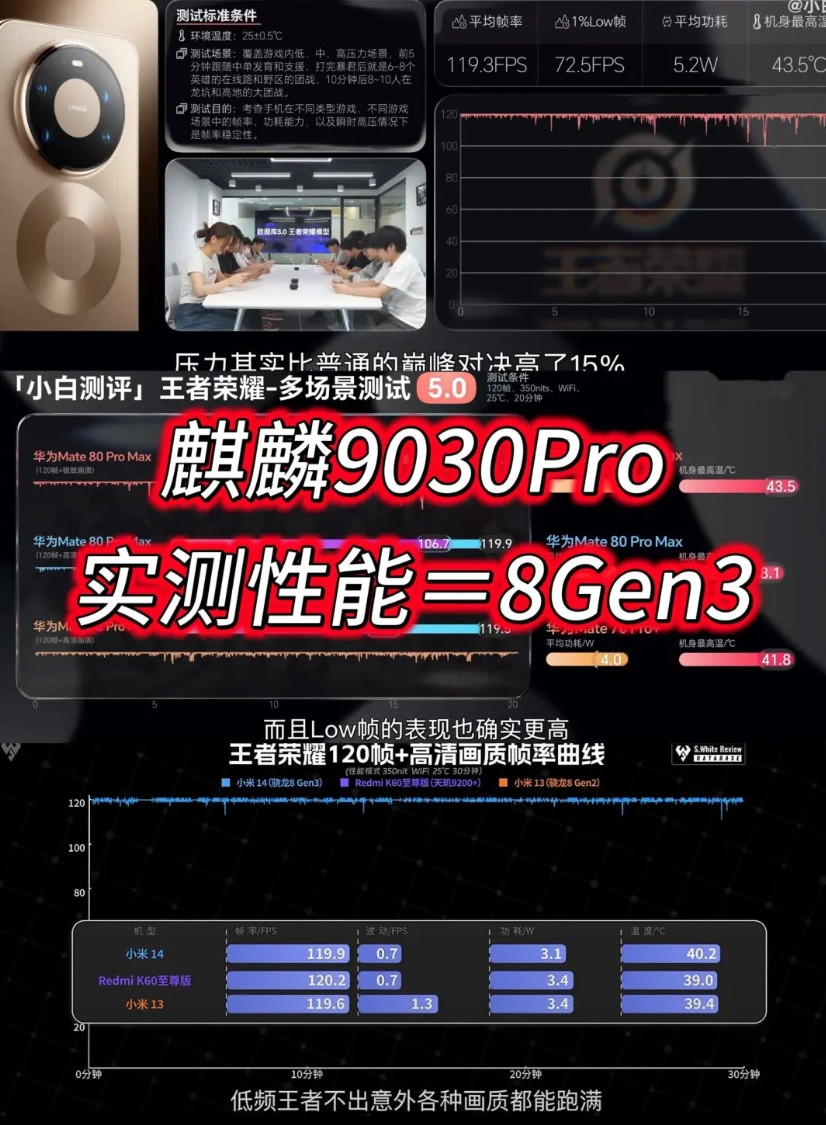

衡量本地大模型运行效率的核心指标之一是 Tokens/s (每秒生成Token数),它直接决定了AI应用响应的流畅度。权威评测机构近期使用主流开源框架(如Ollama)对当前热门处理器进行了本地推理测试,结果令人瞩目:

搭载麒麟9030 Pro的设备: 实测运行 Qwen3-30B-A3B (一个总参数量305亿、激活参数量33亿的高效混合专家模型)时,平均推理速度达到 ~48.93 Tokens/s。这意味着它可以相当流畅地处理复杂的文本生成、分析等任务。

搭载苹果A19 Pro的设备: 在运行 相同模型 (Qwen3-30B-A3B) 的对比测试中,其平均推理速度约为 ~32.5 Tokens/s。虽然这个成绩本身在移动端已属顶级,但相较于麒麟9030 Pro,仍有明显的效率差距。

简单来说,麒麟9030 Pro在运行这个30B级别大模型时,速度比A19 Pro快了约50%! 这个差距在实际体验中尤为显著。想象一下同样的AI写作助手或代码生成工具,一个反应迅速“文思泉涌”,一个则需要你耐心等待——效率高下立判。

快,不只是峰值:麒麟9030的秘密武器

麒麟9030 Pro能在本地AI推理上取得领先,并非偶然,而是多重创新的合力:

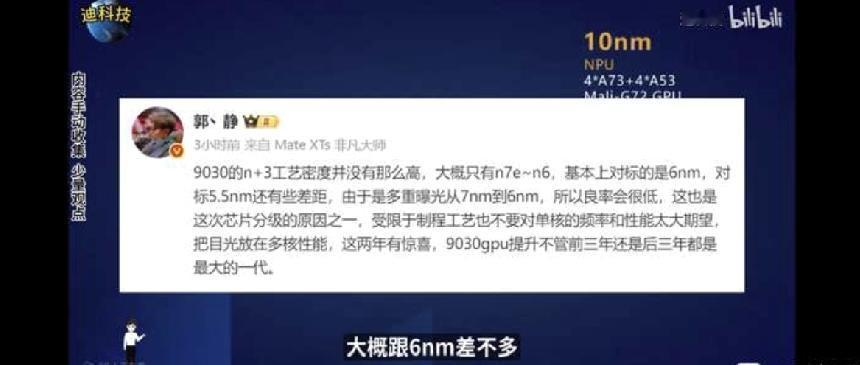

强悍架构 & 先进工艺: 麒麟9030系列采用创新的 1+3+4 三丛集CPU架构和业界领先的 N+3 制程工艺。这使得其性能较上一代提升约 20% ,为复杂计算提供了坚实基础。更强大的计算核心意味着更高效地处理模型计算任务。

专为AI优化的NPU: 华为在AI领域深耕多年,麒麟芯片内置的神经网络处理单元(NPU)是其杀手锏。虽然具体TOPS(万亿次运算每秒)数据未在搜索结果中明确列出,但与A19 Pro的对比数据已经充分证明了其在 实际模型推理任务 中的卓越效率。这表明其NPU设计在 能效比 和 支持复杂模型 方面具有独特优势。

本地部署框架的适配与优化: 麒麟平台积极拥抱开源AI生态系统。像 Ollama 这样的轻量级框架已经成为在麒麟设备上本地流畅运行Qwen3等大模型的热门选择。良好的软硬件协同优化,让麒麟9030的计算潜力得以充分发挥。

本地AI全民化:效率提升意味着什么?

麒麟9030在30B模型推理效率上的突破,其意义远超跑分本身:

旗舰手机=强大AI工作站: 用户无需依赖云端或昂贵的高端PC,就能直接在手机上体验接近PC级的复杂大模型能力,如长文档总结、创意写作辅助、复杂逻辑推理等。

隐私与安全的飞跃: 本地运行意味着用户的敏感数据和对话内容无需上传至云端,从根本上杜绝了隐私泄露风险,为用户数据安全筑起坚实壁垒。

普惠AI的加速到来: 在功耗和成本控制上,手机芯片先天具有优势。麒麟9030证明,高效能本地AI无需以牺牲续航或支付高昂价格为代价,让更多普通用户也能享受到前沿AI的便利。

结语:小芯片撬动大未来

麒麟9030 Pro在本地运行30B大模型上展现出的超越A19 Pro的效率,是国产芯片攀登技术高峰的又一有力印证。它不仅仅是一个速度的提升,更是将“强大AI装进口袋”这一梦想加速照进现实的关键一步。当旗舰手机也能化身AI推理小能手,我们完全可以期待,一个更智能、更便捷、更个性化的移动AI新时代,正在麒麟芯的推动下,呼啸而来!

![麒麟9030Pro性能实际表现接近天玑9400+[思考]这个结果是不是很意外?知](http://image.uczzd.cn/13041092205162153530.jpg?id=0)

![三星的三折叠对比华为三折叠[滑稽笑]只能说折叠屏只有华为和其他[捂脸哭]无论是折痕还](http://image.uczzd.cn/17955064809943217425.jpg?id=0)