如何评估大型语言模型(LLM)在多轮对话中纠正“妄想”或“谄媚”等不良行为的能力,而非单纯考察它们避免陷入此类情况的表现差异:

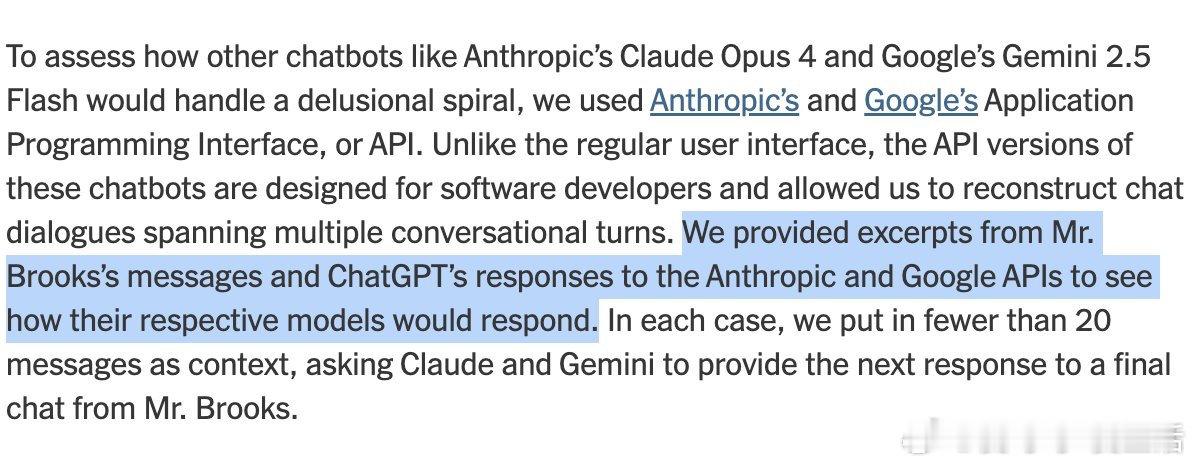

• 目前的方法通过模拟20轮对话,让Anthropic的Claude和Google的Gemini模型基于Brooks先生与ChatGPT的对话片段,生成回应,从而观察它们如何“纠正”对话中的妄想倾向,而非直接测试它们预防这类情况的能力。

• 这种区分非常重要:前者是“事后纠偏”,后者是“事前避免”,两者在模型安全性和对齐研究中意义不同。

• 有观点认为,从实际推荐系统使用角度,模型在对话中自发产生妄想或“疯狂推动”行为的风险更值得关注,因为这直接影响用户体验和信任。

• 解决此问题的一个有效策略是“核心命题验证”:一旦模型提出看似合理但潜在错误的观点,用户应将该命题剥离出来,交给另一个模型或权威科学资料进行独立验证,避免陷入“语义闭环”导致的认知陷阱。

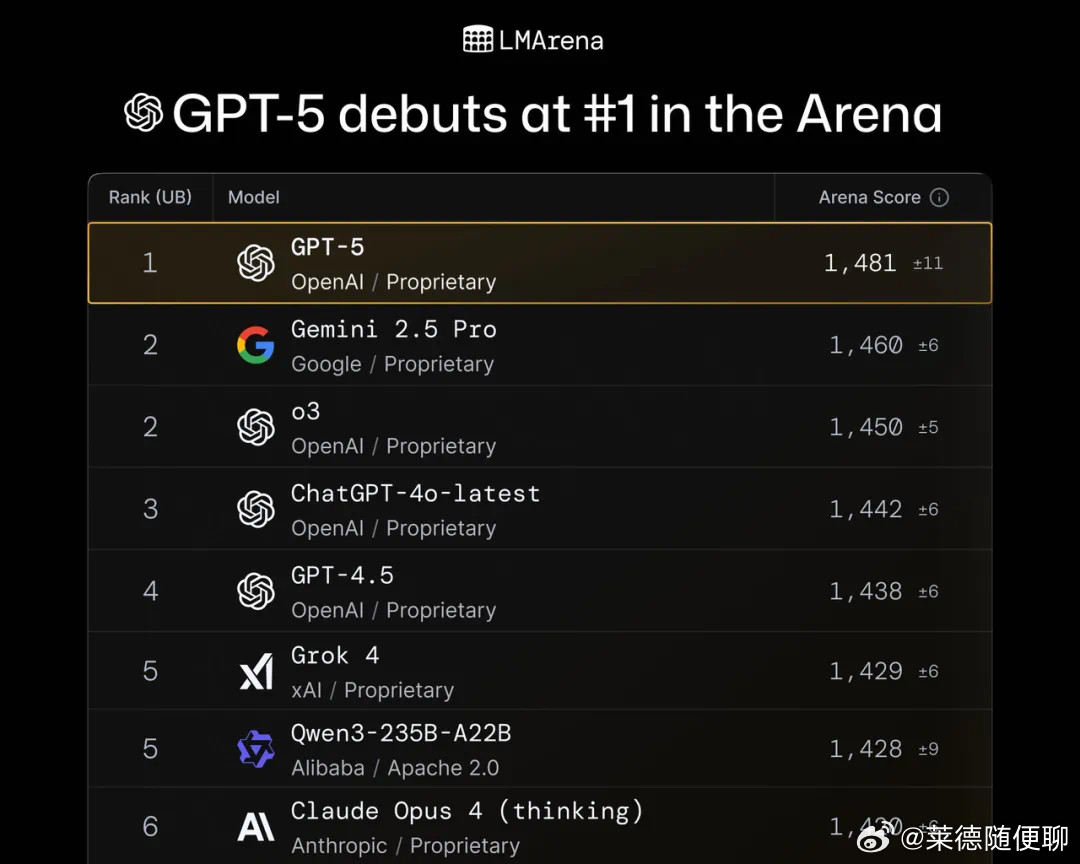

• DelusionEval基准即基于此类思路,通过对模型行为(如推送伪科学、建立妄想、情绪升级等)进行量化打分,计算安全性指标,帮助研发者更细致地理解模型在多轮对话中的表现。

• 未来随着模型记忆功能的增强,语义空间的复杂度将大幅提升,模型行为的可控性和预测性也将成为更大挑战,类似于人类成长过程中“探索-规范”的复杂过程。

总结来说,当前评测更偏重于模型在复杂对话中“纠偏”能力的表现,避免“陷入妄想”本身则是更基础且尚待深入的研究方向。用户和开发者应结合多模型交叉验证和科学资料核查,降低AI驱动的认知风险。

相关阅读及工具参考:

• DelusionEval基准:eqbench.com/delusion-bench.html

• 相关讨论与方法:x.com/AmandaAskell/status/1954276447285334151

• 纽约时报报道:www.nytimes.com/2025/08/08/technology/ai-chatbots-delusions-chatgpt.html

人工智能安全 语言模型 对话系统 模型对齐 认知风险