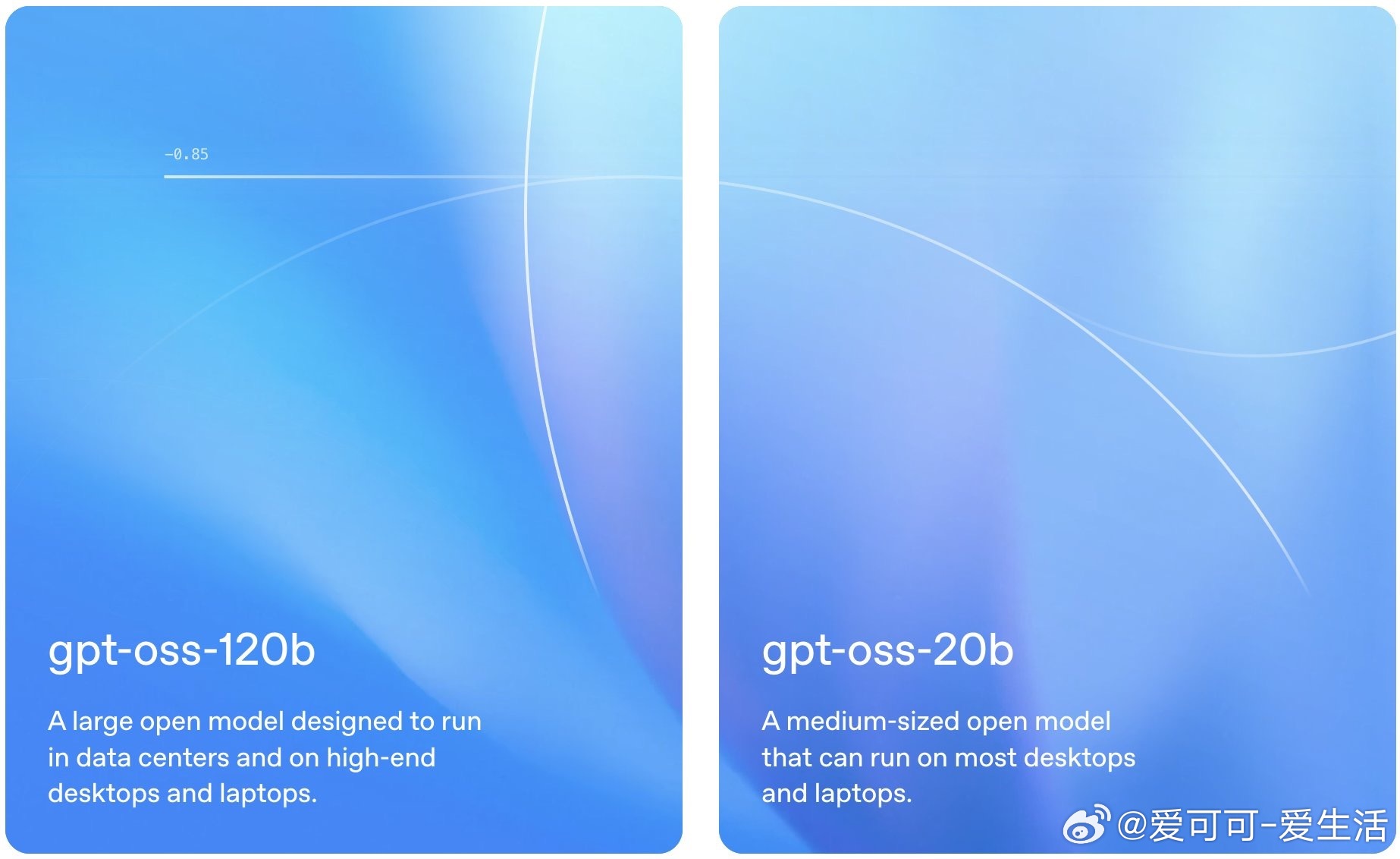

OpenAI刚刚发布了两个开源权重语言模型:gpt-oss-120b和gpt-oss-20b,这是自2019年GPT-2以来首次发布开源模型,标志着OpenAI在开放性策略上的重大转变。

一、模型概况

1. gpt-oss-120b:

- 参数量:117B(总参数),5.1B(活跃参数)。

- 架构:混合专家模型(MoE),使用MXFP4量化(4.25位/参数)。

- 硬件需求:可在单张NVIDIA H100 GPU(80GB)上运行。

- 性能:接近OpenAI o4-mini,在推理任务上表现优异。

- 应用场景:适合生产环境、高推理需求的任务。

2. gpt-oss-20b:

- 参数量:21B(总参数),3.6B(活跃参数)。

- 硬件需求:可在16GB内存的消费级硬件(如高端游戏笔记本)上运行。

- 性能:媲美OpenAI o3-mini,适合低延迟和本地化部署。

- 应用场景:边缘设备、本地推理、特定任务定制。

二、主要特性

- 许可协议:Apache 2.0,无复制限制或专利风险,适合实验、定制和商业部署。

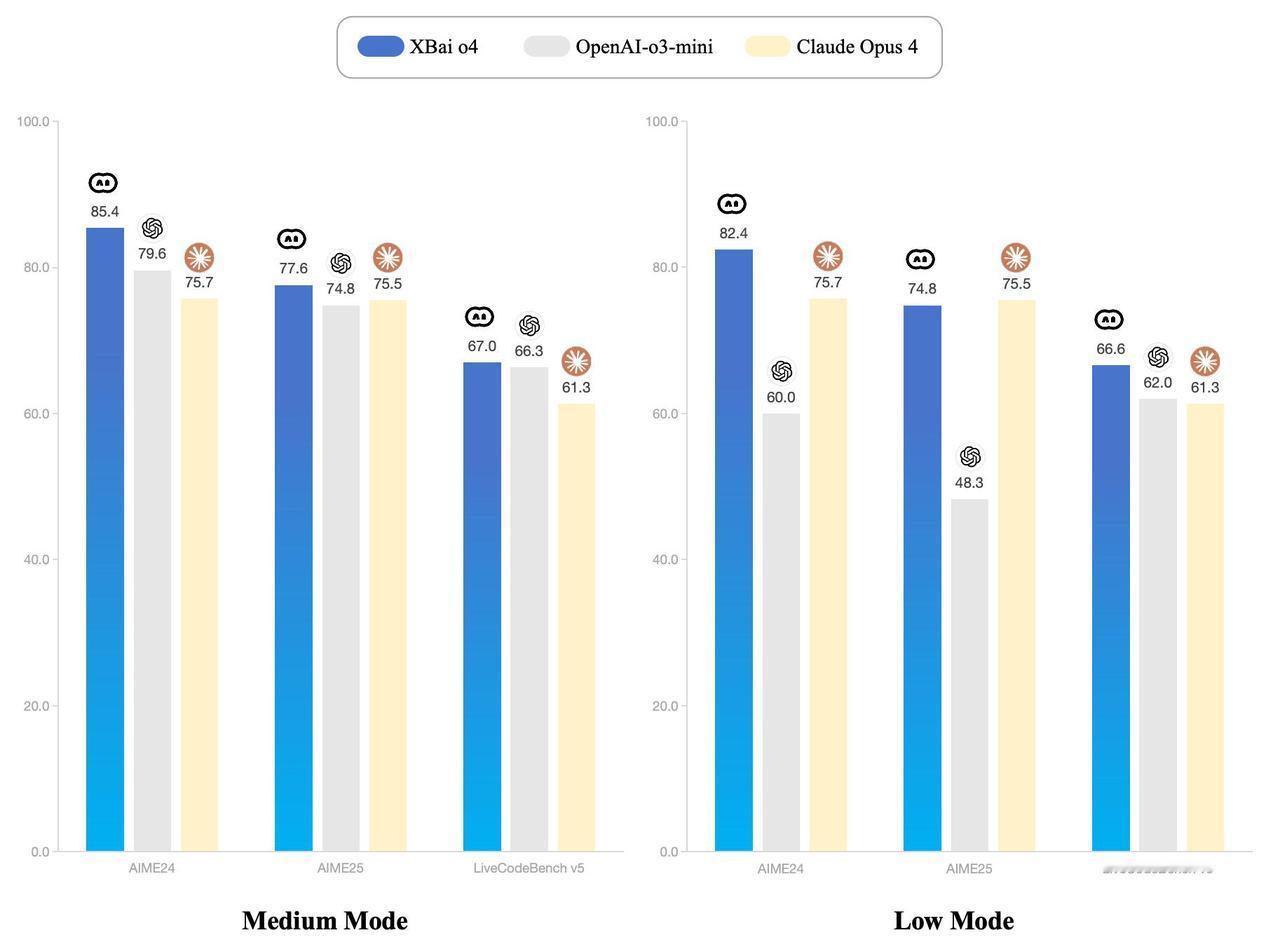

- 推理能力:支持链式推理,可配置推理强度(低、中、高),以平衡速度和性能。

- 工具使用:支持函数调用、网页浏览、Python代码执行和结构化输出(JSON、YAML等)。

- 量化优化:MoE层使用MXFP4量化,降低内存占用,优化推理效率。

- Harmony格式:模型需使用OpenAI的harmony响应格式,否则无法正常工作,与OpenAI Responses API兼容,便于从开源到专有模型的迁移。

- 上下文长度:支持高达128k token的上下文窗口,采用稠密和稀疏注意力机制。

三、安全与测试

- 安全措施:OpenAI对模型进行了全面安全训练和评估,模拟恶意微调场景。测试表明,即使经过恶意微调,gpt-oss-120b在生物、化学和网络风险领域未达到高风险水平。

- 红队挑战:OpenAI发起红队挑战,奖金池50万美元,鼓励研究人员发现潜在安全问题。

- 外部审查:模型训练和评估过程接受三组独立专家审查,优化了安全流程。

四、部署与支持

- 下载与运行:

- 可通过Hugging Face、Ollama、LM Studio等平台免费下载。

- 支持框架:Transformers、vLLM、PyTorch、Triton、llama.cpp等。

- 提供openai-harmony库,简化模型交互。

- 硬件兼容性:

- NVIDIA RTX GPU(16GB+ VRAM)、AMD Instinct(ROCm支持)。

- 可通过Microsoft AI Foundry Local在Windows上运行。

- 微调:两者均支持微调,gpt-oss-20b可在消费级硬件上微调,gpt-oss-120b需H100节点。

五、战略意义

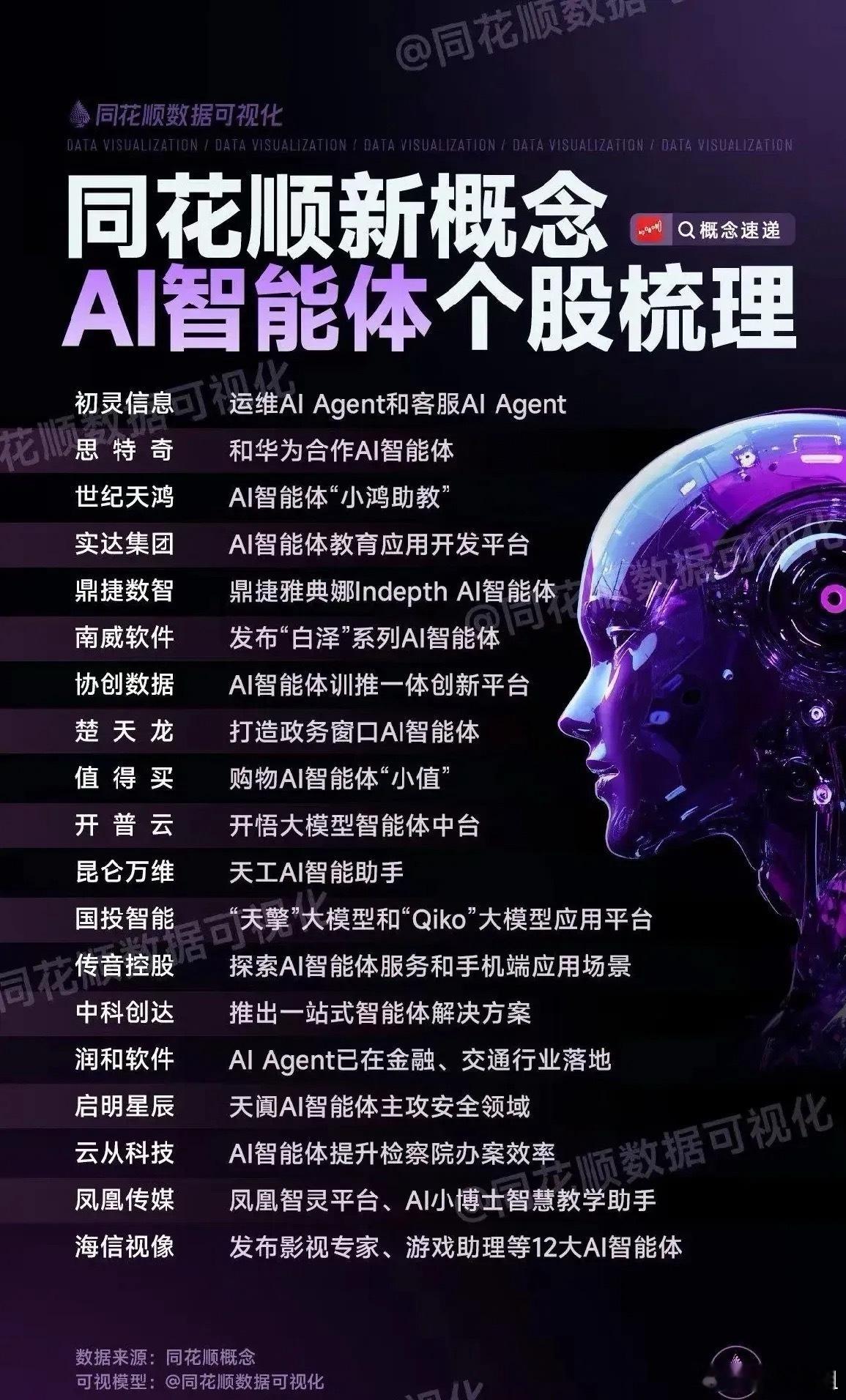

- 市场竞争:回应DeepSeek、Meta、Mistral等开源模型的竞争,巩固OpenAI在开发者社区的地位。

- 开放生态:推动本地化部署,满足隐私敏感行业(如金融、医疗)需求,降低对云服务的依赖。

- 商业策略:通过开源模型吸引开发者,培养使用OpenAI生态的习惯,为未来向专有模型(如GPT-4o)迁移铺路。

六、局限性

- 仅限文本:不支持多模态(图像、音频等),与OpenAI专有模型相比功能受限。

- 性能差距:在某些基准测试(如Humanity's Last Exam)中,gpt-oss-120b(19%)落后于Google Gemini Deep Think(34.8%)。

七、社区反响

- 社交媒体对gpt-oss的发布反响热烈,认为其性能和本地运行能力是重大突破,称其为“最出色、最实用的开放模型”。

- 开发者社区(如Hugging Face)对Apache 2.0许可和低硬件需求表示欢迎,认为这将推动AI代理开发和创新。

总结

gpt-oss-120b和gpt-oss-20b的发布是OpenAI重返开源领域的标志性举措,提供高性能、本地化、灵活的AI模型,兼顾安全性和开发者友好性。通过Apache 2.0许可和低硬件门槛,OpenAI不仅回应了开源竞争,还为开发者提供了构建AI代理和本地应用的强大工具,同时为其专有模型生态铺平道路。欲了解更多,可访问Hugging Face或OpenAI官网。

详情🔗 openai.com/zh-Hans-CN/open-models

大语言模型TransformerMixtureOfExpertsRoPEAttentionSinksGPTOSS机器学习人工智能